MIT新算法骗过神经网络3D物体分类,成功率超90%

以往认为对抗样本虽然能骗过神经网络分类器,但由于缺乏可迁移性,攻击现实世界系统成功可能性很低。MIT的研究人员开发了一种新的算法,生成的对抗样本能够在各种角度、光线下,骗过常用的神经网络分类器,精度高达90%以上。这项工作表明,对抗样本攻击对现实世界的影响比想象中更大。

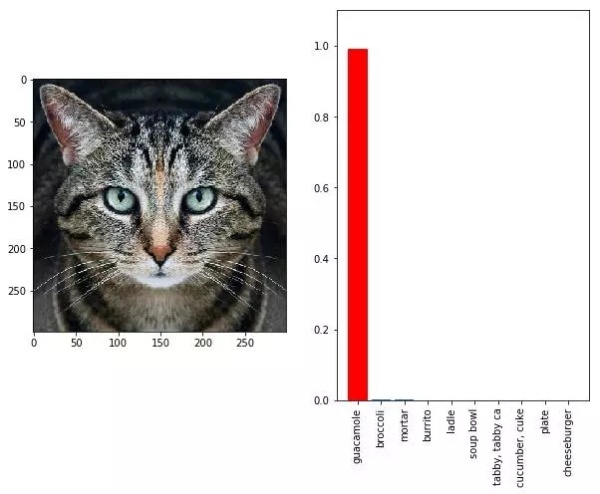

基于神经网络的分类器在许多任务中达到接近人类的表现,在很多现实世界系统中也有应用。然而,这些神经网络特别容易受对抗样本(adversarial examples)的影响,这些对抗样本经过特殊设计,会导致物体被错误分类,比如下面的虎斑猫,使用对抗样本,干扰谷歌InceptionV3图像分类器,系统将人眼一看即知的虎斑猫分类成鳄梨调味酱。

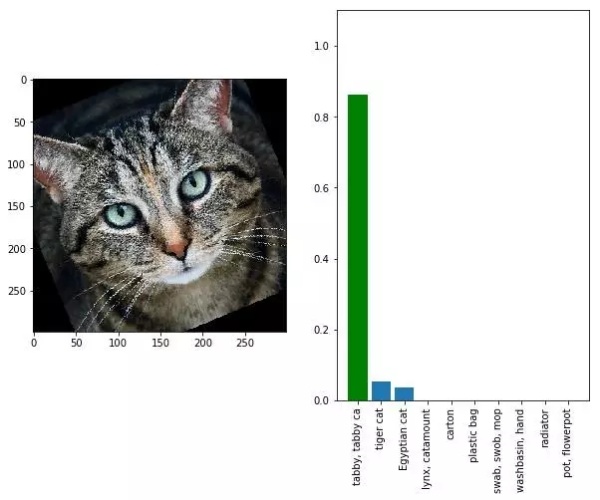

但是,使用标准技术生成的对抗样本,迁移到现实世界中就不管用了,因为数据总会受变焦、相机噪声和其他的影响。例如下面,还是一样的图像,但稍微经过一些旋转,就被正确分类为虎斑猫。

但是,使用标准技术生成的对抗样本,迁移到现实世界中就不管用了,因为数据总会受变焦、相机噪声和其他的影响。例如下面,还是一样的图像,但稍微经过一些旋转,就被正确分类为虎斑猫。

自从发现对抗样本缺乏可迁移性这一特点,很多工作就认为,使用对抗样本进行现实世界攻击的成功可能性很低。而下面要介绍的这项工作表明,对抗样本对现实世界的影响,可能比以前想的更为严重。

自从发现对抗样本缺乏可迁移性这一特点,很多工作就认为,使用对抗样本进行现实世界攻击的成功可能性很低。而下面要介绍的这项工作表明,对抗样本对现实世界的影响,可能比以前想的更为严重。

合成鲁棒的对抗样本,进行稳定的现实世界攻击

MIT和LabSix的研究人员合作,提出了一种合成对抗样本的通用(general-purpose)算法。这种算法生成的对抗样本,在模糊、旋转、缩放、光照等变换下,能够可靠地攻击神经网络分类器,导致目标被错误分类。作者在论文《Synthesizing robust adversarial examples》中写道,“我们提出的方法构建的3D物体,能够在各种角度和视角分布上始终愚弄神经网络,这在业界尚属首次。”

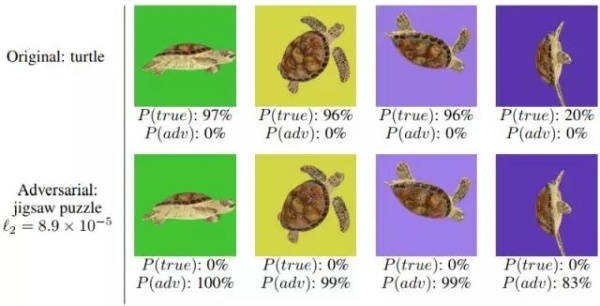

在实验中,研究人员3D打印了一只乌龟,在新的鲁棒合成对抗样本攻击下,在每个角度,谷歌InceptionV3图像分类器都把这只乌龟分类为“步枪”,而不受干扰的乌龟一直被归类为“乌龟”。

论文插图:随机目标3D对抗样本,第一列(绿色),以置信度100%被错误分类

论文插图:随机目标3D对抗样本,第一列(绿色),以置信度100%被错误分类

在这篇论文中,作者秒速了他们如何在2D和3D情况下生成具有可迁移性的对抗样本。此外,他们还展示了,使用新方法在物理世界中合成和制作这种稳定的3D对抗样本,包括具有复杂形状的物体:在实验中,无论视点、噪声和其他类似的现实世界因素如何,这些对抗样本都保持其攻击性。

为了表示他们的过程适用于任意3D模型,研究人员还做了一个棒球,无论从什么角度看,受攻击的分类器都将这只棒球分类为浓缩咖啡。

当研究人员把乌龟和棒球放到语义相关的背景下(比如在水里,或者放在棒球手套中),神经网络仍然无法正确分类(一般而言,步枪不会出现在水下,棒球手套里也极少会有浓缩咖啡)。

新算法EOT:生成鲁棒的对抗样本

这种算法名为EOT(Expectation over Transformation),作者在论文中介绍,ETO算法“关键在于在优化过程中对干扰建模。具体说,不是对一个单一样本的对数似然优化,而是选择形变函数t的分布T做优化”。

简单说,这种算法拿到对抗性样本后,会模拟这个物体从各种角度和距离看上去的结果,然后将所有这些潜在的图像组合成一个单一的模式。

但是,这种方法也有局限——攻击者必须了解目标算法的内部运作。相比之下,以往的对抗攻击可以做到黑箱攻击。

作者在结论中写道,这项工作表明,对抗性样本对基于神经网络的图像分类器构成了实际的威胁。“通过引入EOT,并在EOT框架内进行3D建模渲染和3D打印,我们成功地打印出3D物体,在各种角度、视点和照明条件下,让标准的ImageNet分类器将物体分类为目标类别。”

如果我们不设法找到防御方法,系统总有一天会遭受攻击。论文作者、参与这项研究的Anish Athalye在接受QZ采访时表示,现在有很多使用机器学习的欺诈检测系统,如果能故意修改输入,让系统无法检测出欺诈交易,那么就可能造成财务损失。

相关论文:

https://arxiv.org/pdf/1707.07397.pdf

{replyUser1} 回复 {replyUser2}:{content}